Jak a v čem měříme informaci?

Dušan Polanský

Když se podíváte na obrázek níže, vidíte, že majitel se o zahradu ani zahradní domek nestará a vše díky působení povětrnostních vlivů postupně chátrá. Ovšem nejen kvůli jim. Proti majiteli zahrady nenápadně pracuje i druhý zákon termodynamiky, který říká, že entropie našeho vesmíru roste, tedy že vše má tendenci směřovat k více pravděpodobnému stavu, tedy méně uspořádanému neboli příroda více miluje chaos než pořádek. Entropie je funkce stavu systému, čím je systém ve větším nepořádku, tím je jeho entropie větší. Entropie nemá ráda pořádek, pokud chcete vědět proč podívejte se na konec textu do doplňku, do něhož jsem zařadil jednoduchý důkaz (je k nalezení snad ve všech sbírkách či učebnicích fyziky) této skutečnosti. Dalo by se ukázat, že entropie systému těsně souvisí s informací, kterou o tomto systému máme. Jenomže co to vůbec informace je, jak se měří?

Informace je slovo, jehož významu každý z nás intuitivně rozumí. Obvykle informací rozumíme data, které mají pro nás mají nějaký význam, jsou pro nás často i prakticky využitelné nebo nás o něčem, co nás zajímá, spravují (schválně jsem nenapsal informují). Ovšem v technické či vědecké teorii a praxi potřebujeme informaci nějak měřit, podobně jako měříme např. vzdálenost, hmotnost či čas. No a když chceme něco měřit musíme mít především danou veličinu jasně definovanou, abychom věděli, co je její základní jednotkou. Vzpomínám si, že v jedné kreslené pohádce z mého dětství zvířátka v pralese měřila délku hada v papoušcích. A proč ne? Je to jenom otázky dohody!

Nejtěžší pojem z matematického aparátu, který v našem výkladu použijeme, bude pojem logaritmu. Na střední škole se učí logaritmy o základu 10, tzv. dekadické logaritmy, a o základu e, tzv. přirozené logaritmy. Využijeme poučku, že logaritmus podílu dvou čísel, lze získat odčítáním logaritmu čitatele od logaritmu jmenovatele. Ovšem čeká nás malé překvapení: v teorii informace se používají logaritmy o základě 2. Proč? To si za chvíli vysvětlíme, ačkoliv dnes v době informatiky to pro nás nebude nijak veliké překvapení, jelikož i malí školáci ví, že vše v počítačích je uloženo v jakýchsi buňkách, které mohou obsahovat pouze dvě číslice, buď 1, nebo 0. A veškeré kapacity se měří v bitech, potažmo v jeho násobcích. A také víme, že zkratka b znamená bit a B znamená byte, což je 8 bitů.

Další pojem s kterým budeme pracovat, je pojem pravděpodobnosti. Pro nás stačí když budeme vědět, že míru možného uskutečnění určitého jevu nazýváme pravděpodobnost. Pravděpodobnost je pak dána zlomkem, podílem počtu příznivých výsledků k hledanému jevu a počtu všech možných výsledků. Například při poctivém házení „necinknutou“ hrací kostkou (krychle, pravidelný šestistěn, hexaedr, jinak jedno z pěti platónských těles) je počet všech možných výsledků roven 6, může padnout 1 nebo 2 nebo 3 nebo 4 nebo 5 nebo 6. Pravděpodobnost pádu šestky je pak 1/6, jelikož pouze jeden výsledek je příznivý pádu 6.

Začneme několika jednouchými příklady, které nám pomohou pochopit metodu měření množství informace.

V sevřené ruce mohu, ale nemusím mít minci. Vy nevíte, zda minci v ruce mám, nebo nemám. Z hlediska vás jsou možné 2 alternativy: minci v ruce mám, nebo minci v ruce nemám. Můžeme říct, že před pokusem hodnota chybějící informace je 2, jelikož jsou dvě možné alternativy. Když ruku otevřu, zjistíte, která alternativa platí. Protože alternativy byly 2, tak množství získané informace po otevření ruky je N = 2. U hrací kostky to bude podobné. Před hodem kostkou je 6 alternativ. Jakmile kostku hodím, a padne konkrétní číslo, získám informací N = 6. V případě neznalosti mého dne narození v daném roce by N bylo 365, tedy pokud jsem se nenarodil v přechodném roce 366 den.

Z těchto jednoduchých příkladů je jasné, že množství chybějící informace vedoucí k správnému výsledku je závislé na počtu možných alternativ. Čím více alternativ, tím chybějící informace je větší. Chybějící informaci někdy říkáme i míra neurčitosti nebo entropie. Možná někteří z vás pojem entropie znají z fyziky, konkrétně termodynamiky nebo statistické mechaniky. Není náhoda, že se používají stejné pojmy v různých oborech, ale vysvětlení proč tomu tak je, by bylo trochu náročnější na délku textu a je mimo cíl tohoto krátkého informativního textu.

Teď trochu jiný příklad. Myslím si číslo od 1 do 16. Ptám se, maximálně kolika otázkami zjistíte, které číslo si myslím? Pochopitelně může stačit i jedna otázka, pokud se trefíte napoprvé, kupříkladu zeptáte se, zda je to např. číslo 6, a já si opravdu budu myslet číslo 6. Ovšem nám jde o maximální počet otázek. Takže zkusme si naaranžovat možný dialog dotazů a odpovědí.

Otázka č. 1: Je myšlené číslo menší než 9.

Odpověď č. 1: Ne.

Závěr č. 1: Musí to být některé z čísel 9, 10, 11, 12, 13, 14, 15, 16.

Otázka č. 2: Je myšlené číslo menší než 13.

Odpověď č. 2: Ano.

Závěr č. 2: Musí to být některé z čísel 9, 10, 11, 12.

Otázka č. 3: Je myšlené číslo menší než 11.

Odpověď č. 3: Ano.

Závěr č. 3: Musí to být číslo 9, nebo 10.

Otázka č. 4: Je to číslo 10.

Odpověď č. 4: Ne.

Závěr č. 4: Je to číslo 9.

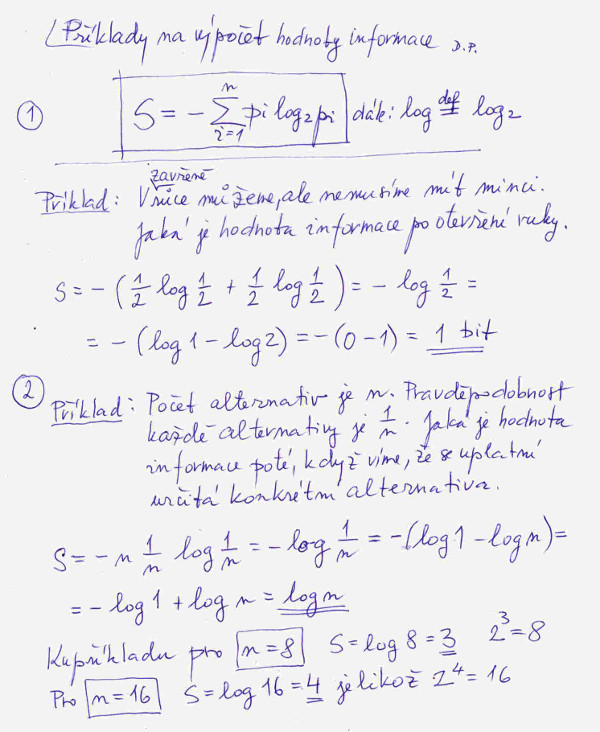

Zdá se, že maximum počtu otázek, které by nám mohly 100 % zjistit v našem příkladu myšlené číslo, by mohlo být 4. Lze dokázat, že je to pravda. A teď taková nenápadná zajímavost: 24 = 16. Za chvíli si dokážeme, že to není náhoda. Tedy bez složitého dotazování mi stačilo umocnit číslo 2 na vhodný exponent, aby mi vyšlo číslo 16, a mám odpověď na maximální počet otázek potřebných k zjištění myšleného čísla. Možná nás teď až tak nepřekvapí, že v roce 1948 americký matematik Claude Etwood Shannon (1916 – 2001) definoval chybějící informaci jak je uvedeno ve vzorci č. 1 na obrázku č. 1. Číslo obrázku zjistíte po najetí kurzoru myši na obrázek. Tedy chybějící informace neboli entropie je součet součinů pravděpodobnosti různých alternativ a logaritmů (se základem 2) těchto pravděpodobností s opačným znaménkem. Tahle definice je to nejdůležitější z tohoto povídání, pokud si ji zapamatujete a především pochopíte, víte to hlavní z teorie informace.

Proč je v našem vzorečku znaménko mínus? Důvod je, že pravděpodobnost je vždy číslo menší než 1, a jak ze školy víme, logaritmy čísel menších než 1 jsou záporné, no a my chceme, aby nám výsledky vyšly kladné. Měřit v záporných jednotkách je dost proti praxi. A vůbec v čem vlastně měříme množství informace? Nejmenší počet alternativ je 2. Když spočítáme hodnotu S vyjde nám 1, viz výpočet na obrázku. No a tahle jednotka míry chybějící informace se zove bit. Přesně stejný bit jak jej známe z informatiky, tedy např. z údaje o velikosti paměti v PC. V binární paměti je na konkrétní pozici zapsaná buď 1, nebo 0, tedy jsou možné pouze dvě alternativy.

Jinak ve všech knihách o teorii informace najdete tabulku, která udává mocniny čísla 2 od 0 do 100. Pochopitelně dnes to umí každá vědecká kalkulačka.

Na obrázku č. 1 je spočten pro úplnost ještě jeden příklad, a to pro všeobecný případ n alternativ se stejnými pravděpodobnostmi, tedy 1/n. Výsledek pak je, že S = log n. To je i důkaz správnosti výpočtu našeho příkladu s uhodnutím čísla od 1 do 16.

Vidíme, že Claude Shannon definoval pojem informace velice šťastně a hlavně prakticky. Pro snadnější počítání se používá funkce, jež je definovaná na obrázku č. 2 pod bodem č. 1. Také její hodnoty bývají uvedeny v tabulce. Proč se tahle pomocná funkce zavádí? Doteď jsem vždy uvažovali příklady, kdy pravděpodobnost všech alternativ byla stejná, kupříkladu u kostky platí pro každou alternativu, že pravděpodobnost je 1/6. V případě n alternativ by to bylo 1/n. Ovšem v praxi tomu vždy tak není, spíš je to výjimka. Představme si systém, který může být v pěti stavech. Jeho pravděpodobnosti jsou uvedeny pod bodem č. 2 na obrázku č. 2. Spočítejme míru neurčitosti pro tento systém. Výpočet vidíte na obrázku. Míra neurčitosti vyšla velice malá. Proč asi? No proto, že stav x5 má vysokou pravděpodobnost, takže pokud si tipneme, že systém bude v stavu x5, a trefíme se, tak to nebude žádný projev naší geniality. Chybějící informace před našim odhadem opravdu nebyla veliká. A ještě jeden výpočet, viz druhý příklad. Stav x3 je tutovka, ostatní pravděpodobnosti jsou nulové. Jaká je chybějící informace? Žádná, tedy 0.

Když Claude Shannon pojem informace zaváděl, myslel především na měření propustností informačních kanálů. Jenomže pojem informace je daleko šířeji použitelný než na měření propustnosti informačních kanálů či kapacit pamětí ve výpočetních prostředcích. Kupříkladu celou formální strukturu kvantové mechaniky lze vyjádřit pomocí dvou postulátů, které pracují s pojmem informace.

A hlavně nesmíme se nechat zmást reálným životem. Máme tendenci se domnívat, že množství chybějící informace by se mělo zmenšovat, vždyť o světě víme toho stále víc a víc. Bohužel současná teoretická fyzika nám říká, že prostor i čas jsou zrnité. Tedy že existuje jakýsi minimální prostor, který již nejde dál dělit, podobné je to časem, ten také není nekonečně dělitelný. Z toho titulu i naše informace o jakémkoliv fyzikálním systému mají konečnou mez. Pokud vás tahle divočina více zaujímá, obstarejte si nějakou knihu o kvantové gravitaci, a tam se dozvíte další podrobnosti. Kupříkladu u nás vyšel v roce 2018 v nakladatelstvích Argo a Dokořán populárně-vědecký titul Carlo Rovelli: Realita není, čím se zdá s podtitulem Cesta ke kvantové gravitaci. Nemusíte se náročnosti textu z pohledu matematiky bát, vystačíte s matematikou z našeho povídání. Pokud jde o entropii z pohledu termodynamiky, potažmo statistické mechaniky, doporučuji jakoukoliv kvalitnější učebnici fyziky. Ovšem předem upozorňuji, že se jedná o poměrně náročnou látku i z hlediska použitého matematického aparátu. A to je vše.

V Brně 24. října 2021.

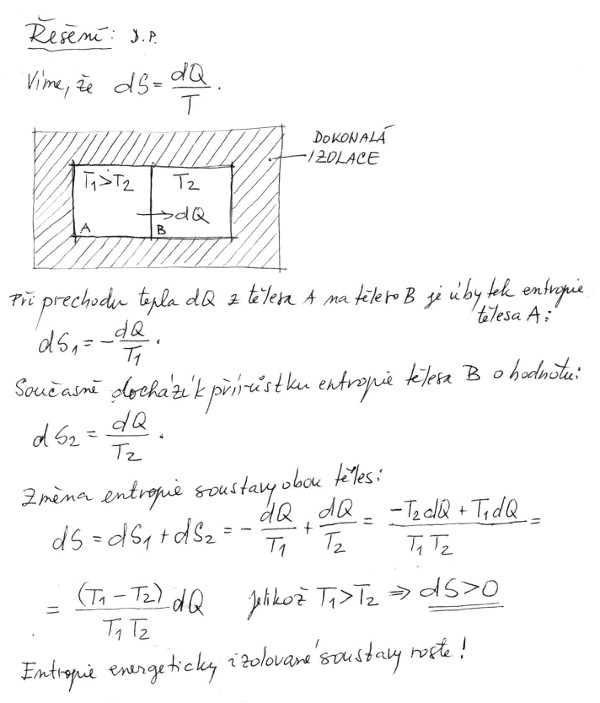

Doplněk o zákonitosti růstu entropie. Entropie je definována takto: dS = dQ/T. Slovy: Malý přírůstek (to je to písmenko d) entropie se spočte jako podíl malého přírůstku tepla při teplotě T (v kelvinech). Teď malý příklad na výpočet změny entropie, který nám ukáže, že entropie méně uspořádaného systému je větší než toho stejného, ale uspořádaného.

Mějme dvě telesa, A a B, které se vzájemně dotýkají a jsou od okolí dokonale izolovaná. Teplota tělesa A je na počátku experimentu větší než tělesa B. Z praxe víme, že po čase se teploty těles vyrovnají. Spočteme celkovou změnu entropie po tomto vyrovnání a zjistime, zda entropie našeho izolovaného systému po vyrovnání bude větší, nebo menší než na počátku experimentu.